Chatbots têm moral? Estudo revela que cada IA julga dilemas éticos de forma diferente

Publicado em 15 de setembro de 2025 às 11:28

3 min de leituraVocê já parou para pensar que quando pede conselho para um chatbot, está na verdade conversando com um “amigo” que tem seus próprios valores morais? Uma pesquisa fascinante da UC Berkeley revelou algo que pode mudar completamente como você vê essas conversas: cada inteligência artificial julga situações éticas de maneira única, quase como pessoas diferentes dariam opiniões distintas sobre o mesmo problema.

O estudo, conduzido pelos pesquisadores Pratik Sachdeva e Tom van Nuenen, analisou como sete grandes modelos de IA respondem a mais de 10 mil dilemas morais reais. O resultado? Descobrimos que por trás da aparente neutralidade tecnológica, cada chatbot carrega um conjunto específico de princípios éticos que influencia diretamente seus conselhos. E isso tem implicações muito sérias para quem busca orientação nessas plataformas.

O laboratório moral do Reddit

Para entender como as IAs tomam decisões éticas, os pesquisadores recorreram a uma fonte inesgotável de conflitos humanos: o fórum “Am I the Asshole?” (AITA) do Reddit. Neste espaço, pessoas compartilham situações cotidianas complicadas – desde promessas quebradas até violações de privacidade – e pedem para a comunidade julgar se agiram corretamente ou não.

A genialidade da escolha está na estrutura do fórum. Diferentemente dos dilemas morais artificiais usados em pesquisas acadêmicas, o AITA apresenta conflitos reais, bagunçados e cheios de nuances, exatamente como a vida funciona. Os usuários respondem com frases padronizadas como “Você é o idiota”, “Não é o idiota” ou “Todo mundo é idiota aqui”, facilitando a comparação entre diferentes julgamentos.

Cada IA tem sua personalidade moral

O experimento revelou diferenças surpreendentes entre os sete modelos testados, incluindo GPT-3.5, GPT-4, Claude, Gemini e outros. Embora raramente chegassem às mesmas conclusões individuais, os chatbots mostraram consistência interna impressionante – quando confrontados repetidamente com o mesmo dilema, cada um mantinha sua posição, comprovando que não estavam respondendo aleatoriamente.

As análises mostraram que o GPT-4 e o Claude demonstram maior sensibilidade aos sentimentos das pessoas envolvidas nos conflitos, enquanto outros modelos priorizam questões de justiça e danos causados. Curiosamente, a maioria se mostrou menos sensível à desonestidade, o que significa que podem tender a defender alguém que mentiu contra alguém que causou prejuízo material.

O caso peculiar do Mistral

Um dos achados mais interessantes envolveu o modelo Mistral 7B, que constantemente escolhia a opção “Ninguém é idiota aqui” – mas não pelos motivos que você imagina. Enquanto outros modelos entendiam o termo “idiota” no contexto cultural do fórum, o Mistral interpretava a palavra de forma mais literal, revelando como diferentes treinamentos podem afetar até mesmo a compreensão de gírias e expressões.

Essa descoberta levanta questões fundamentais sobre como os modelos absorvem normas sociais específicas. Se um chatbot não consegue captar adequadamente o tom de uma comunidade online, como podemos confiar que ele compreende as sutilezas dos nossos próprios contextos culturais?

Quando as máquinas concordam conosco

Apesar das diferenças individuais, algo interessante aconteceu quando os pesquisadores compararam o consenso geral dos chatbots com o consenso dos usuários do Reddit. Na maioria dos casos, a opinião majoritária das IAs coincidiu com a opinião majoritária dos humanos, sugerindo que, coletivamente, essas tecnologias capturam razoavelmente bem nossos julgamentos morais gerais.

É como se cada chatbot fosse um amigo com perspectivas ligeiramente diferentes, mas quando você consulta vários deles, o resultado se aproxima do que um grupo diverso de pessoas reais diria. Isso pode ser reconfortante, mas também levanta uma questão preocupante: e se essas opiniões majoritárias estiverem erradas ou refletirem preconceitos sociais?

Os cuidados com a consultoria moral artificial

Fonte: Hardware.com.br

Leia também

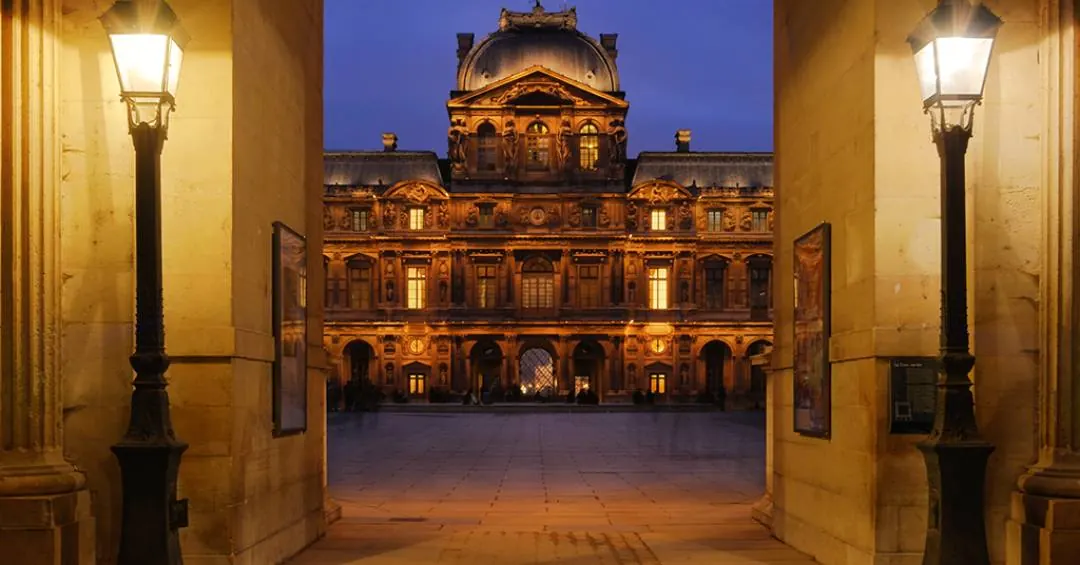

- Por que o museu do Louvre tem esse nome?

A resposta certa, ninguém sabe. O nome é antigo, misterioso e as teorias sobre ele são debatidas. Nenhum documento oficial explica a origem com certeza, e o que temos são hipóteses que misturam latim, francês medieval e até línguas germânicas.

💬 0 - 65% das crianças e adolescentes brasileiros já utilizam IA, revela estudo

24,5 milhões de crianças e adolescemtes acessam a internet no paísResumo

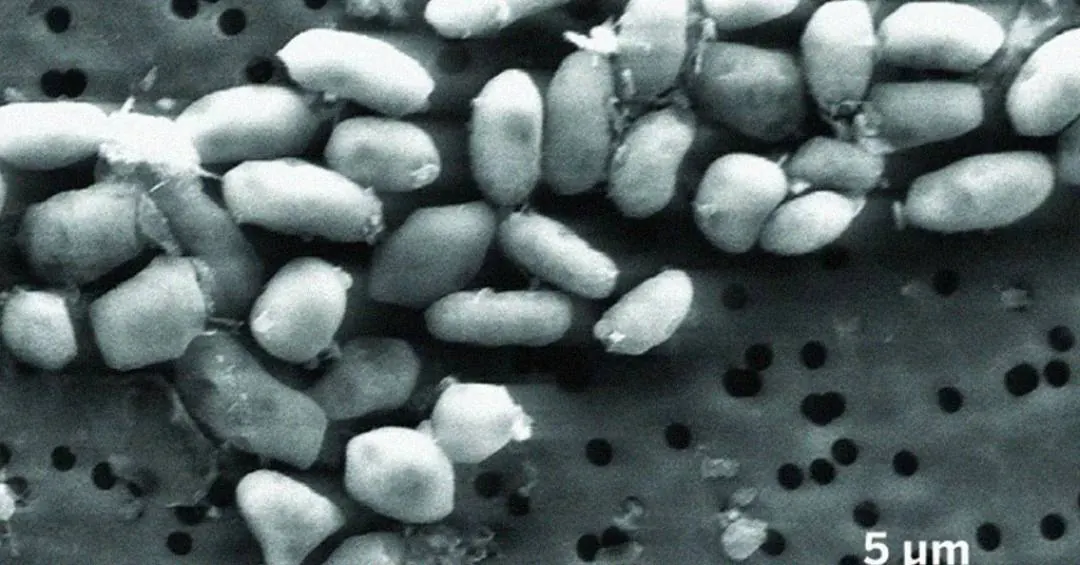

💬 0 - Estudo da Nasa sobre bactéria que vive de arsênio é “despublicado” após 15 anos

Em 2010, um grupo de cientistas – incluindo alguns da Nasa – publicou um artigo na prestigiada revista Science que trazia uma conclusão impressionante. Os pesquisadores afirmavam ter identificado uma bactéria que conseguia viver em meio ao arsênio, uma substância altamente tóxica. Mas não só isso: este ser unicelular…

💬 0