OpenAI abre vaga para líder em previsão de riscos catastróficos da IA

Publicado em 29 de dezembro de 2025 às 11:52

2 min de leituraA OpenAI está à procura de um profissional para ocupar o cargo de Head of Preparedness, posição que terá como principal responsabilidade prever e mitigar possíveis riscos catastróficos relacionados ao avanço da inteligência artificial. O anúncio foi feito pelo CEO Sam Altman através de uma publicação em sua conta no X, onde reconheceu que o rápido avanço dos modelos de IA apresenta “desafios reais” que precisam ser gerenciados.

We are hiring a Head of Preparedness. This is a critical role at an important time; models are improving quickly and are now capable of many great things, but they are also starting to present some real challenges. The potential impact of models on mental health was something we…

— Sam Altman (@sama) December 27, 2025

Na vaga publicada no site oficial da empresa, a OpenAI busca alguém que será responsável por rastrear e se preparar para capacidades de fronteira que possam criar novos riscos de danos severos. A pessoa selecionada liderará diretamente a construção de sistemas que permitam à empresa antecipar potenciais problemas críticos antes que se materializem.

OpenAI abre vaga para líder em previsão de riscos catastróficos da IA 2 Entre as preocupações específicas mencionadas por Altman estão impactos na saúde mental das pessoas e os perigos relacionados a armas de cibersegurança potencializadas por IA. Estes pontos destacam a crescente consciência da OpenAI sobre as consequências imprevistas que suas tecnologias podem desencadear à medida que se tornam mais sofisticadas.

A criação deste cargo surge em um momento de intenso debate global sobre os limites éticos e riscos existenciais da inteligência artificial avançada. A empresa, responsável pelo desenvolvimento do ChatGPT e outros modelos de linguagem de grande porte, tem enfrentado tanto elogios por sua inovação quanto críticas por potencialmente avançar tecnologias sem compreender completamente suas ramificações.

Para quem se interessar pela posição, a vaga de Head of Preparedness exigirá um profissional capaz de navegar entre questões técnicas complexas e considerações éticas profundas, enquanto desenvolve estratégias para monitorar e controlar os riscos associados aos avanços mais recentes em IA.

Especialistas em segurança de IA têm apontado que esta movimentação da OpenAI pode representar um reconhecimento tardio de preocupações levantadas há anos pela comunidade acadêmica. A corrida para desenvolver sistemas de IA cada vez mais poderosos tem gerado apreensão entre pesquisadores que temem que o ritmo de avanço supere nossa capacidade de garantir que essas tecnologias permaneçam seguras e alinhadas com valores humanos.

Você também pode gostar dos artigos abaixo:

Pânico no bastidor? OpenAI está em “alerta máximo” para tentar frear o avanço do Gemini

IBM vê só 1% de chance de superinteligência com a IA atual e põe OpenAI na berlinda

Fonte: Hardware.com.br

Leia também

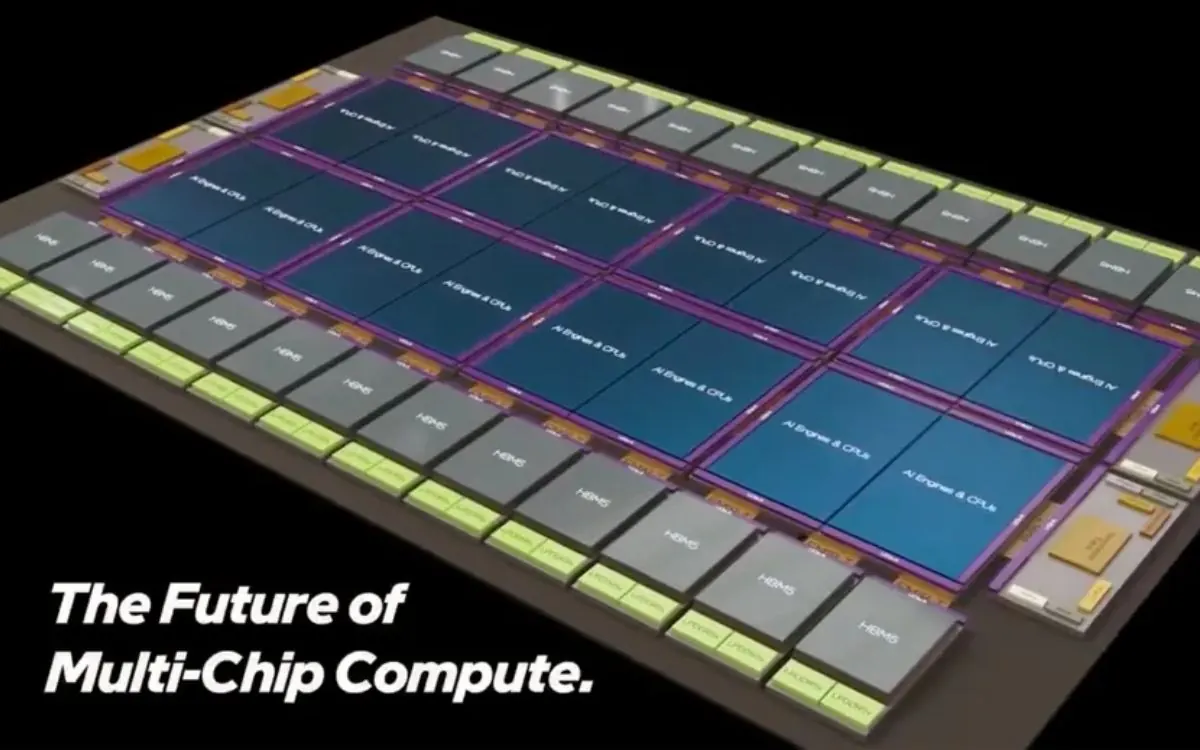

- Intel mostra conceito para multi-chiplet 12 vezes maior que chips IA da atualidade

A Intel foi às redes sociais mostrar como pretende ultrapassar a concorrência na fabricação de chips avançados nos próximos anos. Unindo tecnologias 2,5D e 3D de fabricação e envelopamento, a empresa quer criar um multi-chiplet que chega a ser 12 vezes maior do que os principais chips para processamento de IA na atual…

💬 0 - Fábrica chinesa usa robôs humanoides para testar baterias 24 horas por dia e triplica produção

A CATL, maior fabricante de baterias para carros elétricos do mundo, começou a usar robôs humanoides nas linhas de montagem de suas fábricas na China. A decisão marca uma virada na automação industrial: em vez de máquinas especializadas e fixas, a gigante chinesa preferiu robôs com formato humano, capazes de se adapta…

💬 0 - OpenAI decide trazer o megaprojeto Stargate para a América do Sul

OpenAI e Sur Energy construirão data center focado em IAResumo

💬 0